可解释性是可信AI的核心特征

人脑的决策通常是一个逻辑和推理的过程,技术的使用者会同样希望人工智能模型能具备一定的透明度,能够描述、监督、重现分析和决策的逻辑和判断过程,以及使用和创立的数据来源、动态变化等。易观分析认为,判断一个人工智能是否可信,包含了被解释、被理解、被信任三个层次的内涵。可解释性是可信的基础,也是公平性、普惠性、可追溯性等特征的前提;相应地,不可解释的AI会带来不同程度的风险和伦理问题。例如,算法歧视相较人为因素更不易察觉,可能会放大公平性偏差,不利于金融的普惠化;机器学习在金融领域的试错成本很高,决策的错误可能会引发严重的信用风险,造成银行损失。

一个可解释的AI是可以在数据点和决策点进行人为复盘和验证的,确保AI做出的决策容易理解,才能放心地使用AI进行银行业务活动,发挥降本增效的作用。在客户评级、信用风险预测、反欺诈、反洗钱、客户画像等银行典型场景中,AI模型的可解释性显得尤为重要。

根据业务的风险要求来平衡AI的可解释性和性能

如今,深度神经网络正在向着更准确、更智能的方向发展,然而算法的精确度和黑盒度也是此消彼长的,越是复杂和精确的模型,解释和理解的难度就越高。模型从黑盒到灰盒再到白盒的过程中,模型的透明度提升,但这并非最终的目的,解释的易理解性、准确性、合理性、一致性、实用性才是关键,更确切地说技术使用者需要评估AI的解释力。从银行业的视角来看,在安全可控的前提下充分发挥人工智能价值,需要根据不同业务场景下风险敏感程度、风控要求、精准性要求的不同,在可解释性与性能之间进行权衡和相应侧重,结合专家经验来提升决策的解析度,逐渐增加人机之间的理解与信任。

综合应用可解释方法帮助业务人员理解和评估

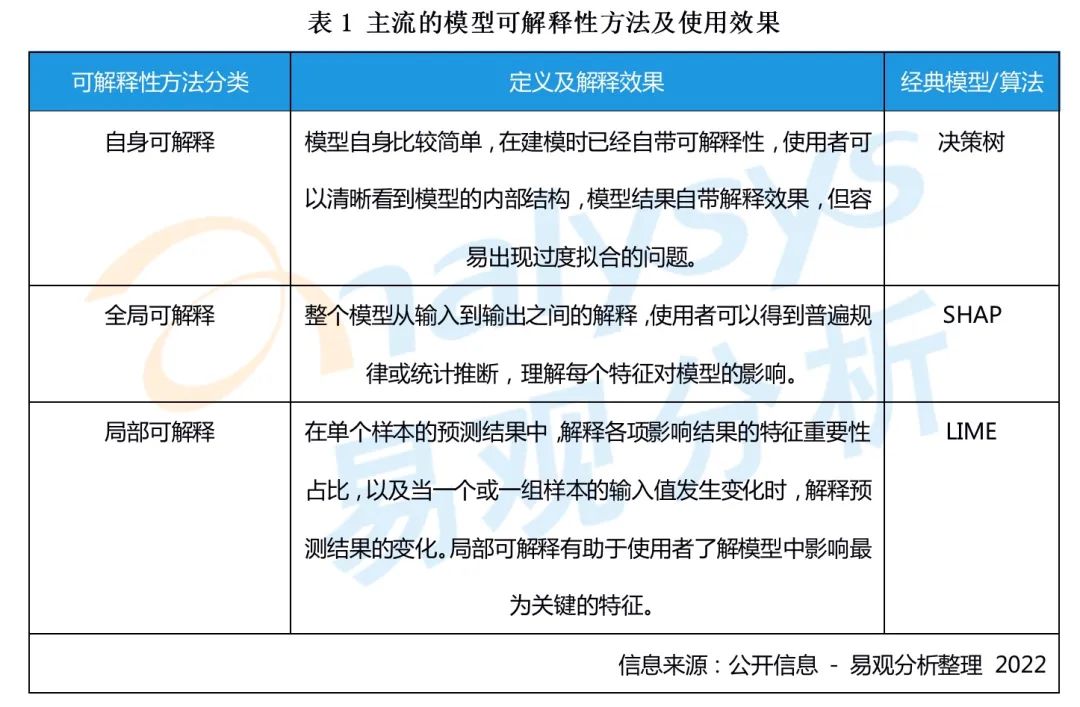

在机器学习领域,目前主流的可解释性方法包括自身可解释、全局可解释、局部可解释等,如下表所示:

银行可结合业务需要进行综合使用,以可视化平台的方式来展现不同样本的预测结果、决策因子和评判标准等,便于在事前或事后理解特征如何影响变量,或是单个样本中的决策逻辑,从而更好地调整业务策略和风险考量。

例如:客户在线上贷款的申请被拒绝后,银行业务人员可以通过局部可解释性看出导致客户未达标的关键因素;或是通过全局可解释性,为业务部门提供整体性的贷款指标定性要求及重要性占比,使业务人员理解哪些特征对提高客户贷款的成功率更重要,协助银行进行精细化的客群经营,提升贷款通过率的同时保证银行风控要求和客户体验。

给银行的两个建议

1.针对不同的应用场景设定不同的解释程度和验证优先级

人工智能可解释性方法的研究目前还处于探索阶段,也尚未形成通用标准的衡量体系,银行业务部门在评估AI的可解释性和性能时,可对不同场景设定相应的透明度、准确度的等级要求。在进行小规模验证时,可优先从客户评级、反洗钱、反欺诈等风险敏感、可解释必要性最高的场景进行验证,其次考虑智能客服等交互场景,再考虑智能推荐等营销场景。

2.以机器学习+专家经验交互协同的模式优化决策模型

可解释是为了使模型变得容易理解,并帮助业务提升和风险防控。因此在使用中需要融入银行业务专家的经验,使专家能够理解并对AI决策的逻辑进行解析,来控制模型和算法风险,并将业务经验反哺到模型中;同时,机器在深度学习和自我优化中,也需要业务专家对特征影响分布的变化、引入新因子带来的决策变化等进行及时评估,在和机器的不断交互和相互理解中提高人机协同的效果。

更多阅读推荐:

》》银行需要明确低代码与无代码开发平台的差异,以便于在技术规划及产品选型上降低试错成本

》》银行业RPA趋向主动触发流程,补足营销场景执行末端的渠道协同能力

微信扫描下方二维码,每日推送更多有趣的数据&有料的报告,记得点赞哦!